数据中心网络技术的演进发展

不平凡的2021终将远去,新的一年新的开始。作为一个老网工历经了数据中心和网络技术的几度变迁,接下来是我的分享。下图就是数据中心网络的一个大致的发展历程,从最开始的以太网技术到今天的SDN+AI,网络越来越智能化和自动发展。

第一次转折,以太网的生死之战

ATM技术

来源于通讯行业的一项技术, 建立在电路交换和分组交换的基础上的一种新的交换技术,ATM技术亮点是可以同时承载语音、视频和数据,通讯行业希望一种技术解决通讯网络和计算机网络(广域网和局域网)完美融合,ATM Cell交换芯片的高速率和低延时,一出来就支持25M/155M/622M, 远超100M以太网,QOS服务质量上: ABR/VBR/CBR 说起来头头是道, 而且当时就提出控制和转发分离基于MPOA 协议统一控制SVC连接,有点类似今天的SDN理念,以当时的技术而言ATM具有绝对的技术优势

千兆以太网GE技术

以太网基于70年代的以太网CSMA/CD机制和技术,当时以太网速率只有 100M,半双工而且共享带宽,QOS最弱或技术基本上谈不上桌面, 初期通讯厂商提出利用ATM技术实现语音数据和视频的融合,技术上全面领先,传统的IBM等公司为保护自己的原有SNA/APPN市场,支持TokenRing/FDDI甚至偏向ATM阵营,以太网节节败退; 战役的后期:以太网速率提高到千兆速率和交换全双工,SNA和IP以太网达成战略同盟:以基于IP+Tunnel的DLSW+兼容和支持SNA/APPN,同时廉价的以太网卡延伸到桌面,基于IP的语音和视频H.323+RSVP帮助IP以太网的SLA服务质量问题,以太网终于开始扭转了生死战局。

总结:ATM/MPoA技术上的优势难以弥补其在通用性的缺点,一方面25M/155M网卡和芯片在价格上企业难以承受, 另一方面是转发层面过分依赖控制层面导致性能和可靠性下降。战役的结果以太网统治了网络界20多年直到今天也无法动摇,确立霸主地位,厂商思科无疑是这场战役的大赢家。

第二次转折,网络大二层技术的兄弟之战

焦点技术1:大二层技术TRILL/L2MP

焦点技术2:OTV和LiSP组合

焦点技术3:FCoE和 DCB

总结:这次演进以云计算和虚拟化开始,数据中心的网络技术开始出现TRILL/FabricPath、OTV/LiSP、DCB/FCoE等一系列眼花缭乱的新东西,由于这是数据中心网络技术的和平演变和网络自身的改革,虽然打着云计算的”幌子”,但是当时厂商也不见得真正知道云计算需要什么,刀片服务器+TRILL+FCoE顶多算是为虚拟化资源池做了最佳实践,或者成果可以算是为虚拟化和多中心服务器应用多活进行的网络实践,因此这次的战役三个网络巨人(思科、华为和H3C)空前达成一致,先后推出的技术惊人的相似,由于没有颠覆性的技术改变格局,大家相安无事,甚至最后存储网络厂商也没有受到任何影响。网工经过这次洗礼,对存储技术,刀片技术,虚拟化技术开始掌握或精通,开始出现跨界网工,那个时代的网络工程师开始要懂一些存储SAN,服务器、灾备、PUE和云计算Vmware。

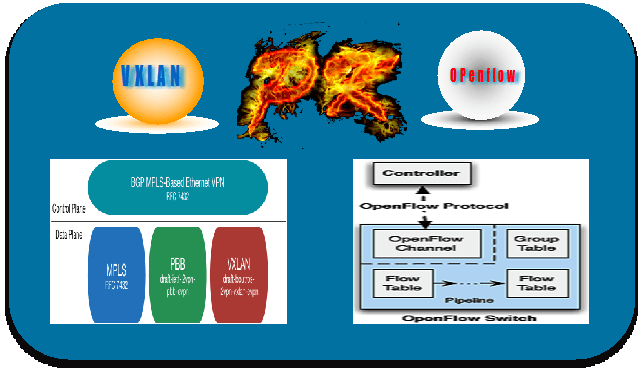

第三次转折,基于SDN的Openflow与VXLAN孰优孰劣

焦点技术1:基于Openflow的SDN技术

焦点技术2:基于VXLAN/EVPN SDN技术

VXLAN(Virtual Extensible LAN)作为一种网络虚拟化技术,采用“MAC in UDP”封装形式并且基于IP网络的实现大二层技术,是一种用于实现大型云计算和数据中心的网络二层互通技术。VXLAN作为一种数据封装技术,其本身没有控制平面,其在转发数据前的表项学习,如arp表、VNI、VTEP地址等都是通过数据包的泛洪来完成,因此VXLAN数据转发前表项学习的泛洪流量一开始就是一个重要难题,好在VXLAN出来后网工们就开始制定它的控制层面的标准- BGP EVPN (RFC7432)标准的出现可谓及时雨宋江,大大促进了VXLAN的快速发展和普及,并为VXLAN和其它Overlay技术竞争中奠定了优势,基于BGP EVPN控制层学习L2和L3的可达信息,通过EVPN完成在VXLAN转发数据报文前ARP表项学习,主机路由学习和VTEP自动发现,VXLAN+EVPN成为云数据中心环境下网络的首选技术,为实现数据中心虚拟化、集群和云部署大二层网络奠定夯实了网络基础。

第四次焦点,基于SDN的Network Overlay与Host Overlay混合组网

混搭模式一 极简中继模式

云宿主机处通过vlan Trunk与VTEP交换机互联, 利用PortVLAN等实现租户VXLAN关联。物理主机资源池为主,兼顾云主机资源池,支持虚拟环境有Openstack (或Vmware 环境)与物理服务器(BM)网络SDN统一管理,实现SDN控制器与Neutron的集成和对接。这种模式自动化部署、部署简单,方便实现云主机和物理主机统一管理;适合:物理主机为主,兼顾虚拟化和云环境的场景推荐使用。

混搭模式二 GW模式

混合Overlay组网分别纳管自动部署,以Host Overlay为主,兼顾HW VTEP逻辑资源池, Neutron负责Host Overlay的管理,SDN控制器负责Network Overlay的管理,各自的Border GW实现打通双方租户信息,这种方式software的GW和hardware的GWHW通常只做L3租户打通,如果做L2打通还需要考虑很多因素包括Anycast GW 以及两边的Mac学习模式一致性等问题? 有人建议合并两个GW,但是由于管理界限不清,也会产生很多问题。这种架构看起来不够完美,如果做L3 租户打通部署相对起来简单, 做L2打通需要设计和考虑复杂一些。适合:云环境主机为主,兼顾物理机的场景推荐使用。

混搭模式三 统一纳管模式

混合Overlay组网由SDN控制器统一纳管,实现租户的VM与BM物理机实现基于VXLAN大二层互通,将VTEP延展到虚机层面。每台宿主机装一套VTEPAgent , 通过Evpn 与其他硬件或软件VTEP建立连接并交换 L2 和L3 entries,租户的VM与BM物理机通过VXLAN实现灵活大二层互通。这种架构理论很好,但是有的厂商VTEP的Peer数量有一定限制,如果VTEP Agent设计不好会造成很大的问题和隐患,当然这种模式也存在被厂商锁定的风险。

闽公网安备 35012102500533号

闽公网安备 35012102500533号